Głosowe interfejsy użytkownika

Zmiana paradygmatu

Dla wszystkich fanów science-fiction koncept głosowego interfejsu użytkownika (VUI- voice user interface) jest znany od dziesięcioleci. Każdy, kto wiele lat temu oglądał Star Trek lub 2001: Odyseja Kosmiczna spodziewał się pewnie, że około roku 2000 wszyscy będziemy kontrolować komputery za pomocą głosu. Zresztą nie tylko autorzy sci-fi dostrzegali potencjał tego typu interfejsów. W 1986 roku Nielsen zapytał 57 specjalistów z branży IT jaka ich zdaniem będzie największa zmiana w interfejsach użytkownika do roku 2000. Najczęściej wskazywali oni właśnie na rozwój głosowych interfejsów. Nadzieje pokładane w tego typu rozwiązaniach mają swoją przyczynę. Komunikacja werbalna jest przecież najbardziej naturalnym sposobem świadomej komunikacji między ludźmi, więc wykorzystanie tego sposobu do interakcji człowiek-maszyna wydaje się być równie naturalnym rozwiązaniem.

Tymczasem masowo produkowane urządzenia z interfejsem głosowym pojawiały się już w połowie lat 90-tych, ale popularności nie zdobyły. Pierwszym telefonem, który umożliwiał obsługę głosową (wybieranie numeru) był Philips Spark, który pojawił się na rynku w 1996 roku. Reklamowany jako przełomowe i proste w obsłudze urządzenie, nie był jednak wolny od pewnych problemów i ograniczeń technologicznych.

Kolejne telefony (wydawane przez firmy takie jak RIM, Samsung czy Motorola) wyposażone w jakąś formę głosowego interfejsu pojawiały się na rynku regularnie, pozwalając użytkownikom na głosowe wybieranie numeru czy wysyłanie wiadomości tekstowych. Wszystkie one wymagały jednak, aby użytkownicy pamiętali określone polecenia i wymawiali je w wymuszonej, sztucznej formie, dostosowanej do możliwości ówczesnych urządzeń. Generowało to dużą ilość błędów, co w efekcie prowadziło do obniżonej satysfakcji użytkowników.

Najnowszymi rozwiązaniami w dziedzinie VUI są wirtualny asystent Siri (2011) oraz jego Androidowy odpowiednik S-Voice (2012) – pierwsze masowo dostępne i stosowane systemy, które mają szansę na rynkowy sukces (Siri właściwie już ten sukces odniosło). Za sprawą Siri możemy mówić o kolejnej (po interfejsach dotykowych, które upowszechniły się przecież nie tak dawno temu) zmianie paradygmatu w sposobie obsługi i komunikacji z maszynami. Nie oznacza to oczywiście wyeliminowania bardziej tradycyjnych interfejsów – dostępne raczej będą interfejsy hybrydowe – łączące kilka sposobów interakcji.

Zalety i zastosowanie

Wykorzystanie tego typu interfejsów w telefonach wydaje się dobrym rozwiązaniem głównie ze względu na to, że pozwalają na operowanie telefonem bez konieczności klikania, stukania oraz patrzenia na ekran. Teoretycznie więc, w sytuacjach kiedy nie mamy możliwości lub nie powinniśmy korzystać z interfejsów dotykowych (patrz na drogę, obie ręce na kierownicy – mantra instruktorów jazdy), głosowy interfejs jest idealnym rozwiązaniem.

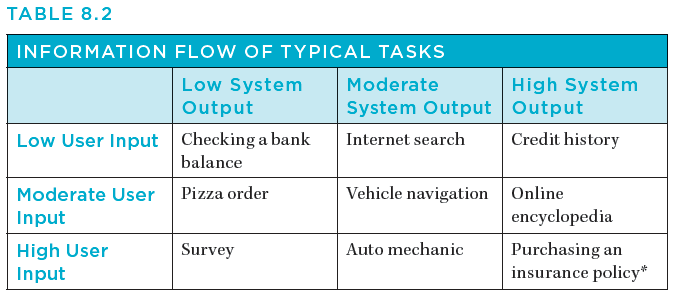

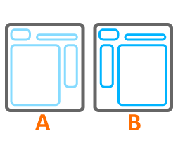

Oczywiście głosowy interfejs nie nadaje się do wykonywania wszystkich zadań w kontekście mobilnym – można za jego pomocą zadzwonić do znajomego prowadząc auto, nawet wysłać mu SMS ale już sprawdzenie ostatnich przelewów może być zbyt skomplikowane ze względu na ilość informacji przekazywanych do systemu (user input) oraz generowanych przez system (system output). Jak sugeruje Rachel Hinman w Mobile Frontier, stosowanie VUI jest najbardziej wydajne podczas wykonywania zadań, w których ilość informacji na wejściu i wyjściu jest niewielka.

(za: “The Mobile Frontier”, Rachel Hinman)

(za: “The Mobile Frontier”, Rachel Hinman)

Innego rodzaju problemem jest skuteczne zaprezentowanie możliwych do wyboru opcji systemowych oraz uniknięcie „zapętlenia” w ich obrębie. Sytuacja jest podobna do problemu znanego choćby z różnego rodzaju linii pomocy gdzie, aby wybrać właściwą opcję, często musimy wysłuchać wszystkich możliwych:

- aby zgłosić kradzież telefonu naciśnij 1…

- aby sprawdzić stan konta naciśnij 2 …

- aby …

Tego typu nawigacja/menu (opierająca się na dużej liczbie opcji oraz ściśle określonej sekwencji ich prezentacji) to chyba jeden z głównych powodów dla których VUI nie odnosiły przez dłuższy czas sukcesu. Oczywiście w dużej części winę za to ponosiły problemy implementacyjne i wdrożeniowe z zakresu chociażby sztucznej inteligencjioraz rozpoznawania mowy. Niemniej, w ostatnim czasie pojawiły się systemy, które pozwalają na operowanie telefonem w sposób przyjazny dla użytkownika, nie są schematyczne i pozwalają w elastyczny sposób wykonać określone zadanie.

Stan obecny

Najlepszym przykładem postępu w obrębie VUI jest Siri. Aplikacja dzięki połączeniu technologii rozpoznawania mowy, przetwarzania języka naturalnego oraz syntezy mowy potrafi trafnie interpretować komendy użytkownika, odpowiadać na pytania nie-wprost (znane Do I need an umbrella today?) czy rekomendować najlepsze rozwiązania. A wszystko to przy użyciu naturalnego języka, bez konieczności znajomości specyficznych dla tego systemu komend. Właśnie Siri jako pierwszy system pokazał jak dobrze VUI może się sprawdzić przy zadaniach typu: wysyłanie maila, dodanie notatki, ustawienie spotkania czy znalezienie znajdujących się w pobliżu restauracji.

Po pojawieniu się Siri pojawiły się głosy, że podobne technologie na rynku istniały od dawna, choćby Google Voice Actions na platformę Android. Jak drastyczna była jednak różnica między nimi można zaobserwować porównując filmy je promujące:

Introducing Voice Actions – Android

Introducing Siri

Podczas, gdy Siri pozwala na swobodną interakcję człowiek – komputer, zbliżając obsługę telefonu do normalnej rozmowy (spełniając tym samym definicję wirtualnego asystenta), produkt Google był zbliżony do bardziej tradycyjnych, sterowanych za pomocą określonych poleceń systemów. W Google Voice Actions, jeśli użytkownik chciałby sprawdzić pogodę w Warszawie to polecenie musiałoby być zbliżone do: Warsaw waether today. A informacja zwrotna była przedstawiana w postaci graficznej na wyświetlaczu. Ale to już przeszłość… W Galaxy S3 dostępny jest już bardziej elastyczny system S-Voice. Porównanie obu systemów można zobaczyć na tym filmie:

Apple jednak nie próżnuje i dalej rozwija Siri – w nowej wersji iOS pojawi się system Eyes-free – dedykowany specjalnie do użycia w samochodzie i zintegrowany z systemami pokładowymi takich firm jak BMW czy Toyota. Eyes-free pozwoli przejąć kontrolę nad większością niekrytycznych funkcji w samochodzie (takich jak klimatyzacja, nawigacja, telefon itp.) bez odrywania rąk od kierownicy. Kontrola głosem wydaje się być tutaj najbardziej sensownym rozwiązaniem (chyba że korzystamy z Google Driverless Car).

Przyszłość

Głos może być doskonałym sposobem interakcji człowiek – komputer ze względu na jego fundamentalne znaczenie w komunikacji między ludźmi. Postęp w obszarze interfejsów głosowych w ciągu ostatnich dziesięciu lat jest znaczący a ich potencjał ogromny. W ciągu najbliższych kilka lat czeka nas przeniesie akcentu na komunikację głosową w urządzeniach mobilnych. I chociaż nie zrezygnujemy całkowicie z dotykowych interfejsów graficznych to przyszłość w tym sektorze technologicznym należy do interfejsów hybrydowych (dotykowo-głosowe). I na projektowanie takich interfejsów będziemy musieli się wkrótce przestawić…

Odpowiedz

Want to join the discussion?Feel free to contribute!